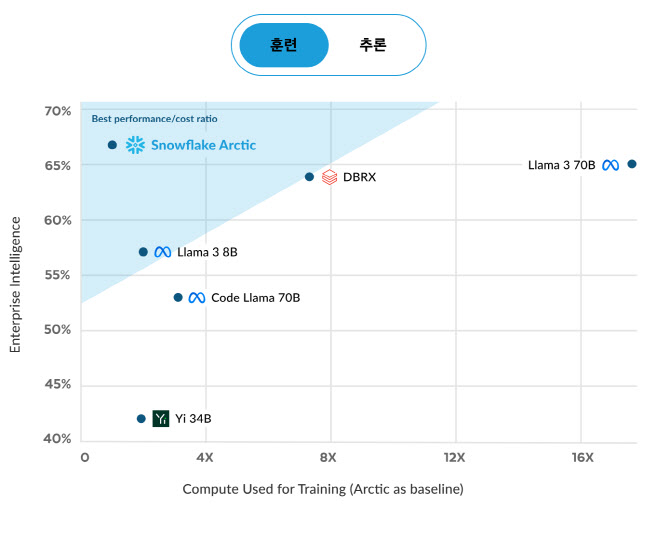

베리스 굴테킨(Baris Gultekin) 스노우플레이크 AI 부문 수석은 지난 10일 이데일리와의 화상 인터뷰에서 “아크틱은 동급의 성능을 지닌 LLM과 비교해 학습 비용이 8분에 1에 불과하다”며 이같이 강조했다.

|

굴테킨 수석은 “SQL(데이터처리언어) 질의 생성, 코딩, 비즈니스 맥락을 이해한 명령 이행 등이 가능한 AI를 엔터프라이즈 인텔리전스라고 부른다”며 “아크틱은 엔터프라이즈 인텔리전스 기준으로 봤을 때 성능과 비용 효율성 모두 최고 수준”이라고 자신했다.

벤치마크에서 아크틱은 엔터프라이즈 인텔리전스를 평가하는 SQL 생성(79%), 코딩(64.3%), 명령 이행(57.4%) 항목에서 모두 우수한 평가를 받았다. 종합적으로는 100% 최고점에 65% 이상의 성능이 확인됐다. 아크틱의 인텔리전스 수치는 DBRX나 라마3 70B와 비슷하지만, 학습에 들어가는 비용은 각각 8분의1, 17분의1 수준으로 더 저렴했다.

|

굴테킨 수석은 “이 방식을 활용해 같은 양의 데이터를 갖고 학습시켰을 때 더 높은 수준의 인텔리전스를 제공할 수 있게 됐고, 활성화된 파라미터에 비례해 비용이 발생하기 때문에 학습 비용도 더 저렴해졌다”고 말했다.

스노우플레이크는 클라우드에서 LLM을 활용하더라도 데이터 보안에 대한 우려가 없도록 기술적·제도적 장치를 완비했다고도 굴테킨 수석은 강조했다. 그는 “모든 고객의 데이터는 스노플레이크의 데이터 보안 기술과 다수의 인증으로 보호된다. 또 스노플레이크 플랫폼 내에서 LLM들은 고객의 데이터로 학습하지 않는다고 (약관에) 명시돼 있다. 이런 안정장치 덕분에 데이터 보안에 가장 민감한 금융권과 헬스케어 분야 기업들도 이미 아크틱을 활용하고 있다”고 설명했다.

아크틱이 오픈소스 LLM이라는 점도 신뢰를 높이는 요인이라는 게 그의 설명이다. 그는 “개발 과정은 물론 그 과정에서 얻은 데이터까지 모두 오픈했다”며 “LLM이 어떤 식으로 개발됐는지를 공개하는 것은 중요하다”고 했다.

끝으로 굴테킨 수석은 “AI를 통해서 비즈니스를 완전히 탈바꿈시킬 수 있는 엄청난 기회가 열렸다”며 “스노우플레이크는 그러한 기회를 찾는 기업들에게 AI와 데이터 플랫폼을 묶어서 가장 강력한 솔루션을 제공할 수 있다”고 강조했다.

![GPT, 나 우울해서 빵샀어 말했더니…남편보다 나은 AI와의 대화[잇:써봐]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24060800137t.jpg)

![‘왕초보' 안유진도 마음 놓고 탄다…‘지락실' 럭셔리 연수용 차는[누구차]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24060800061t.jpg)