단순한 ‘만능 AI’가 아닌, 실제 서비스를 고려한 ‘전문가형 특화 AI’ 개발에 집중하겠다는 전략이 반영됐다.

MoE는 모든 질문에 한 명의 ‘만능 박사’가 답하는 대신, 질문의 종류에 따라 가장 잘 아는 ‘전문가’ 여러 명 중 일부만 선택적으로 답하게 하는 방식이다.

이번에 공개된 두 모델은 각각 △이미지와 텍스트를 동시에 이해하는 ‘Kanana-1.5-v-3b’(경량 멀티모달 모델)와 △효율성과 성능을 모두 잡은 ‘Kanana-1.5-15.7b-a3b’(MoE 모델)로, 카카오는 이를 글로벌 오픈소스 플랫폼인 허깅페이스(Hugging Face)를 통해 공개했다.

|

‘Kanana-1.5-v-3b’는 텍스트뿐 아니라 이미지를 함께 이해할 수 있는 경량 멀티모달 언어모델로, 카카오가 자체 기술로 ‘프롬 스크래치(From Scratch)’ 방식으로 개발한 AI다.

특히 사용자의 질문 의도를 파악하는 지시 이행 능력이 뛰어나며, 한국어·영어 이미지 이해에서도 글로벌 모델 GPT-4o에 견줄만한 성능을 보였다. 실제로 국내 벤치마크에서는 동급 모델 중 최고 점수를 기록했고, 영어 영역에서도 해외 모델과 대등한 수준을 보여줬다.

사진 한 장과 함께 “이 장소가 어디인지 설명해줘”라고 입력하면 “서울 청계천입니다”라는 식의 응답을 제공할 수 있다. 카카오는 이 모델을 이미지 검색, 관광 안내, 문화유산 해설, 콘텐츠 분류, 수학 문제 풀이 등 다양한 분야에 적용 가능하다고 밝혔다.

국내 최초 공개된 MoE 모델… ‘성능과 비용’ 모두 잡다

카카오는 이번에 국내 최초로 MoE 구조를 적용한 언어모델 ‘Kanana-1.5-15.7b-a3b’도 함께 공개했다. MoE는 전체 파라미터(매개변수)중 일부 전문가 네트워크만 작동하는 방식으로, 연산량을 줄여 고성능을 유지하면서도 저비용 운영이 가능한 것이 특징이다.

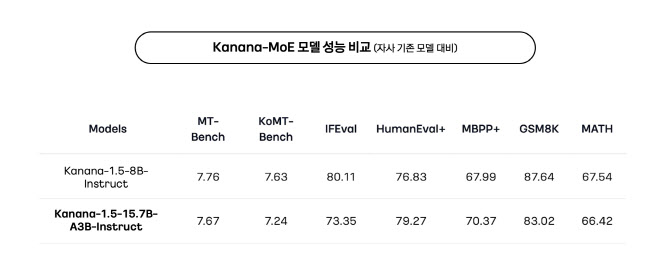

해당 모델은 총 15.7B 파라미터 중 추론 시 단 3B만 활성화되며, 성능은 기존 8B 밀집(Dense) 모델과 동등하거나 그 이상으로 나타났다. 특히 카카오는 자체 경량 모델에 ‘업사이클링’ 기법을 적용해 빠르게 MoE 아키텍처를 구현했다고 설명했다.

이 모델은 클라우드 자원이 제한된 스타트업이나 경량 AI 인프라를 구축하려는 기업에 적합하며, 효율적인 AI 서비스를 원하는 다양한 산업군에서 실용성이 높을 것으로 기대된다.

“모델 자립과 서비스 적용, 두 마리 토끼 잡는다”

카카오는 이번 오픈소스 공개를 통해 ▲AI 모델의 고도화 ▲글로벌 수준 초거대 모델 개발 ▲AI 생태계 확대라는 세 가지 전략을 동시에 추진하고 있다. 특히 이번 모델은 상업적 활용이 가능한 아파치 2.0 라이선스를 적용해 누구나 자유롭게 실험·서비스에 사용할 수 있다.

카카오 김병학 ‘카나나’ 성과 리더는 “이번 오픈소스 공개는 비용 효율성과 성능이라는 두 가지 측면 모두에서 의미 있는 진보”라며 “모델 자립성과 실질적인 서비스 적용을 동시에 고려한 결과물”이라고 설명했다.

앞으로 카카오는 추론형 에이전트 AI, 초거대 멀티모달 모델 등 후속 기술도 순차적으로 공개할 예정이다. 정부의 ‘독자 AI 파운데이션 모델’ 프로젝트에도 참여 중인 카카오는 자사 플랫폼 운영 경험을 바탕으로 국민 누구나 쉽게 AI를 활용할 수 있는 환경 조성에 힘쓴다는 방침이다.