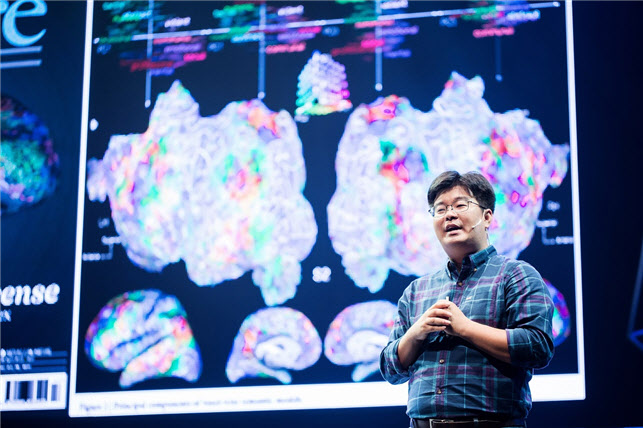

한국과학기술원(KAIST)은 정재승 바이오뇌공학과 교수 연구팀이 3차원 공간상에서 생각만으로 로봇팔을 90% 이상의 정확도(90.9~92.6%)로 조종하는 ‘뇌·기계 인터페이스 시스템’을 개발했다고 23일 밝혔다.

뇌 활동만으로 사람의 의도를 파악해 로봇이나 기계가 대신 행동에 옮기는 ‘뇌·기계 인터페이스’ 기술이 빠르게 발전하고 있지만 손을 움직이는 정도의 의도 파악을 넘어 팔 움직임의 방향에 대한 의도를 파악해 로봇팔을 움직이는 기술은 정확도가 높지 않았다.

연구팀은 이번 연구에서 조종 방향에 대한 의도를 뇌 활동만으로 인식하는 인공지능 모델을 개발했다. 그러면서 3차원 공간상에서 24개의 방향을 해석하는 시스템을 개발했다.

기존 기계학습 기술은 높은 사양의 GPU 하드웨어가 필요했다. 이번 연구는 축적 컴퓨팅 기법을 이용했기 때문에 낮은 사양의 하드웨어에서도 인공지능 학습이 가능하다. 스마트 모바일 기기에 응용하도록 개발해 메타버스와 스마트 기기에도 적용할 수 있다.

정재승 교수는 “뇌파를 통해 생각만으로 로봇팔을 구동하는 ‘뇌·기계 인터페이스 시스템’ 대부분이 높은 사양의 하드웨어가 필요해 실시간으로 응용하거나 스마트기기에 적용하기 어려웠다”며 “이번 시스템은 90%~92%의 높은 정확도를 가진 의도 인식 인공지능 시스템을 만들어 메타버스 안에서 아바타를 생각대로 움직이게 하거나 앱을 생각만으로 조절하는 스마트기기에 사용할 수 있다”고 말했다.

연구 결과는 국제학술지 ‘어플라이드 소프트 컴퓨팅(Applied Soft Computing)’ 올해 3월호에 출판됐다.

|

![누군가는 악몽일 맛 한국 휩쓴 中고수라면…끓여봤더니[먹어보고서]](https://image.edaily.co.kr/images/vision/files/NP/S/2025/06/PS25060100093t.jpg)

!["폐가를 신혼집으로" 결혼 앞둔 서동주가 경매로 산 집[누구집]](https://image.edaily.co.kr/images/vision/files/NP/S/2025/06/PS25060100089t.jpg)