한국데이터법정책학회와 김·장 법률사무소가 공동 주최한 웨비나가 최근 열렸는데, 이 자리에서는 EU AI법의 내용과 한국 기업에 미칠 영향에 대한 전문가 전망이 나왔다.

|

AI법 내용이 뭔데?

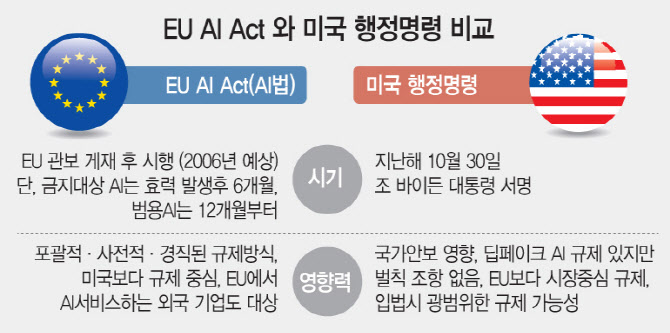

EU AI법은 EU 관보 게재 20일 경과후 효력이 발생한다. (2024.5~2024.6월 예상). 효력 발생후 24개월이 경과된 시점부터 시행되니, 2026년 중반에 시행될 예정이다.

다만, 금지대상 AI 규정은 효력 발생후 6개월 경과 시점, 챗GPT 같은 범용AI(General Purpose AI) 규정은 효력 발생이후 12개월이 지나면 시행된다. 즉 2025년 중·하순부터 오픈AI의 챗GPT, 구글 제미나이는 물론 네이버 하이퍼클로바X 등도 규제대상에 포함되는 셈이다.

김·장 법률사무소의 정유석 변호사는 EU의 AI법의 특징을 설명하면서 ①포괄적 규제를 갖는 기본법(제공자와 배포자), ②위험기반 규제 방식(고위험 금지와 범용AI 구분)을 꼽았다.

배포자인 MS, 구글 클라우드도 규제대상

눈에 띄는 점은 이 법에서 제공자(Providers)와 배포자(Deployers)를 나눈 것이다.

정 변호사는 “AI 시스템을 개발하거나 공급하는 ‘제공자’가 주요 의무를 지지만, 최종 이용자와 접점에 있는 ‘배포자’도 일부 의무를 부담하도록 규정돼 있다고 설명했다.

또한, “제공자에는 개발 회사외에도 자신의 명의로 AI 시스템을 활용한 서비스를 시장에 출시하는 기업이 포함된다”고 부연했다. 예를들면 챗GPT에 문제가 생기면 오픈AI 외에도 이 모델(LLM)을 활용해 가전 제품이나 자동차, 플랫폼 사업을 하는 기업들도 ‘제공자’에 해당한다는 얘기다. 무상으로 제공해도 제공자 규제에 포함된다.

‘배포자’에 대해서는 단순한 AI 이용 사업자가 아닌 AI 시스템을 이용해 서비스를 제공하는 과정에서 통제권, 시스템 개선이나 변경에 관한 권한을 가지고 그 AI 시스템을 이용하는 사업자를 의미한다고 설명했다. 여기선 개인이 비직업적 활동과정에서 쓰는 경우는 제외한다.

이를테면 오픈AI의 챗GPT나 구글 제미나이 등을 파인튜닝(미세조정)해 클라우드로 제공해 주는 마이크로소프트(Microsoft)나 구글 클라우드 등도 ‘배포자’로서 규제 대상이 될 것으로 보인다.

정 변호사는 “EU 내에 있는 제공자나 배포자가 아니어도 AI 시스템이나 AI 모델을 EU 시장 내에 출시하거나, AI 시스템의 산출물이 EU 내에서 사용되는 경우, AI를 탑재한 제품이나 그를 활용한 서비스가 이후 시장 내에 출시되는 경우에는 적용될 수 있다”고 설명했다.

4단계로 위험 분류

EU AI법은 금지대상AI, 고위험AI, 제한된 위험을 갖는 AI, 최소 위험 AI 등 위험 수준에 따라 4단계로 구분된다.

금지대상 AI는 사회적 차별을 심화하거나 개인의 민감한 정보를 추론하는 AI, 국가가 사회 구성원 감시에 영향을 미쳐 자유나 권리가 침해될 수 있는 유형들이다. 원칙적으로 금지되고, 테러리즘 수색 등에만 예외로 허용된다.

고위험AI는 시장 출시 전후에 엄격한 의무가 부과된다. 가장 시장에 미치는 영향이 큰 분야다.

①기계, 장난감 의료기기, 교통수단·설비(차량, 항공기, 선박, 철도시스템), 농업용 장비 등 제품 안전성 관련 위험이 있거나, ②핵심기반시설(전기, 수도, 가수, 교통 등의 안전요소)관리 운영, 입학사정·교육·직업훈련 ③채용과 인사관리 ④본질적으로 중요한 공공 및 민간서비스에 대한 접근(신용평가, 보험요율 산정, 혜택 수혜자 자격요건 판단 등)⑤법집행(증거분석, 금융사기 탐지 등)⑥이민·난민·출입국 관리 같은 보건, 안전, 기본권, 환경 관련 위험이 있는 경우다.

제한된 위험으로 구분받는 AI는 챗봇 등인데, 이는 일정한 사항을 고지하거나 알려야 하는 투명성 의무만 부과된다.

김·장 법률사무소의 정유석 변호사는 “이밖에 자율 규제 대상이 되는 최소 위험 AI들이 있다”면서 “위험 수준에 따라 제재 수준도 달라지고, 당국의 자료 요청에 불충분한 정보 제공시 제재가 있다. 스타트업 등에는 좀 더 낮은 수준의 제재로 규정돼 있다”고 설명했다.

|

한국에는 어떤 영향?

고위험 AI가 논란의 중심이 될 것으로 예상된다. 이는 시장에 출시되기 전에 적합성 평가와 기본권 영향 평가를 받아야 하기 때문이다. 적합성 평가는 AI 시스템을 개발하고 공급하는 ‘제공자’에게 부과되며, 제품 안전성 관련 평가는 외부의 제3자에게 받아야 한다.

또, EU AI법에는 범용 AI 규제가 포함되어 있는데, 위험 기반 분류 체계와 다르다.

위험 기반 분류 체계는 AI 시스템이 실제로 활용되는 분야에 따라 발생할 수 있는 위험의 수준을 고려한 것이다. 반면, 범용 AI 분류 체계는 AI 모델 자체의 능력에 따라 발생할 수 있는 위험을 고려한 것이다.

김·장 법률사무소의 정유석 변호사는 “예를 들어 범용 AI 모델을 활용해 채용 목적으로 개발된 AI 시스템이 있다면 ‘제공자(모델 개발사)’는 범용 모델 위험 기반 분류 체계에, 서비스를 만든 배포자인 AI 채용 솔루션 사업자는 고위험 AI 규제의 대상이 될 수 있다”고 설명했다.

특히 그는 “국내 사업자 중에서도 EU 시장에 AI 시스템이 탑재된 제품을 출시하려는 사업자가 있다면 주의가 필요하며, 예를 들어 AI 시스템이 탑재된 전자기기나 자동차 제조사가 해당될 수 있다”고 덧붙였다.

이어 “AI 서비스를 출시하기 직전에 일부 기능을 수정하는 것으로는 이후 AI 규제를 충분히 준수하기 어려울 수 있기 때문에 AI 시스템과 제품을 기획하거나 개발하는 단계에서부터 컴플라이언스 방안을 검토하는 것이 필요할 수도 있다”고 힘줘 말했다.

![아파트에서 숨진 트로트 여가수…범인은 전 남자친구였다 [그해 오늘]](https://image.edaily.co.kr/images/vision/files/NP/S/2024/11/PS24113000001t.jpg)