|

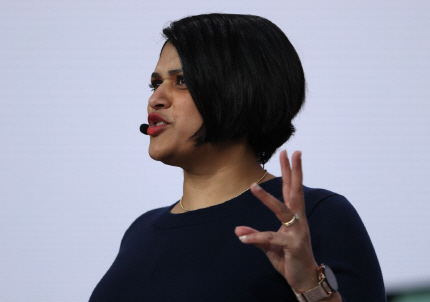

아파르나 체나프라가다(Aparna Chennapragada) 구글 렌즈 및 AR 부문 부사장은 7일(현지시간) 미국 마운틴뷰 쇼라인 앰피시어터에서 열린 구글 I/O 기조연설에서 AR 기술을 활용한 새로운 구글 검색 기능을 소개했다.

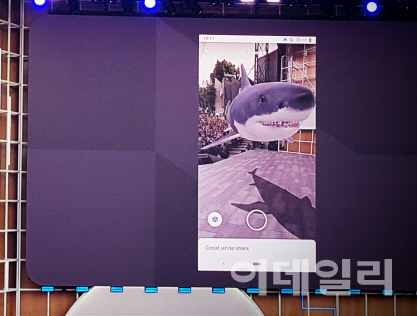

이달 말 출시 예정인 새롭게 도입된 새로운 검색 기능은 구글 검색으로 검색한 3D 이미지에 AR 기술을 접목해 현실에 직접 배치해볼 수 있는 것이 특징이다.

체나프라가다 부사장은 “근육에 대해 공부하는 학생이면 근육을 검색해서 3D 모델을 볼 수 있으며 주변 세상에서 AR을 통해서 볼 수도 있다. 신발을 검색하는 경우라면 바닥이 어떻게 생겼는지, 혹은 다른 옷과 어떻게 어울리는지를 직접 확인하실 수 있다”고 말했다.

그는 이날 현장에서 백상아리 3D 이미지를 검색해 무대와 합성한 모습을 선보이기도 했다. 체나프라가다 부사장은 “백상아리가 어느 정도의 사이즈라는 것을 글로 읽을 수도 있지만 여기 현장에서 띄워보면 실제 어느 정도인지 더 생생하게 볼 수 있다”고 강조했다.

|

아울러 단순 이미지 검색을 넘어 이미지에 연결된 정보를 이어주는 구글 렌즈의 새로운 기능도 이날 소개됐다. 구글은 머신러닝과 컴퓨터 비전, 지식 그래프(Knowledge Graph)의 수백억 개의 정보를 여기 활용했다.

식당 메뉴판을 촬영하면 구글 렌즈는 메뉴 중 인기 잇는 메뉴를 자동으로 추천한다. 화면에서 음식 메뉴를 누르면 구글 지도의 사진과 후기를 바탕으로 해당 요리가 실제로는 어떤 모습이고 또 다른 사람들은 어떠한 후기를 남겼는지 확인할 수 있다.

이 같은 구글 렌즈의 새로운 기능은 현지 언어를 모르는 낯선 장소에 있을 때 유용할 것으로 보인다. 카메라를 글씨에 대기만 하면 렌즈가 자동으로 언어를 감지해 번역된 언어로 보여준다. 구글은 현재 100개 이상의 언어를 지원한다고 밝혔다.

체나프라가다 부사장은 “다른 세상 속 사물과 지식을 연결하려고 노력하고 있다”고 말했다. 구글은 다음 달부터 일부 샌프란시스코의 드 영 박물관에서 구글 렌즈를 이용하면 큐레이터의 작품 설명을 들을 수 있도록 했다. 또 요리잡지 보나페티(Bon Appetit)에 나온 메뉴에 구글 렌즈를 비추면 레시피를 현실로 가져와 요리법을 보여주게 된다.